港大黄超团队推出AnyGraph, 首次揭秘图大模型的Scaling Law

港大黄超团队推出AnyGraph, 首次揭秘图大模型的Scaling Law本文的主要作者来自香港大学的数据智能实验室 (Data Intelligence Lab@HKU)。

本文的主要作者来自香港大学的数据智能实验室 (Data Intelligence Lab@HKU)。

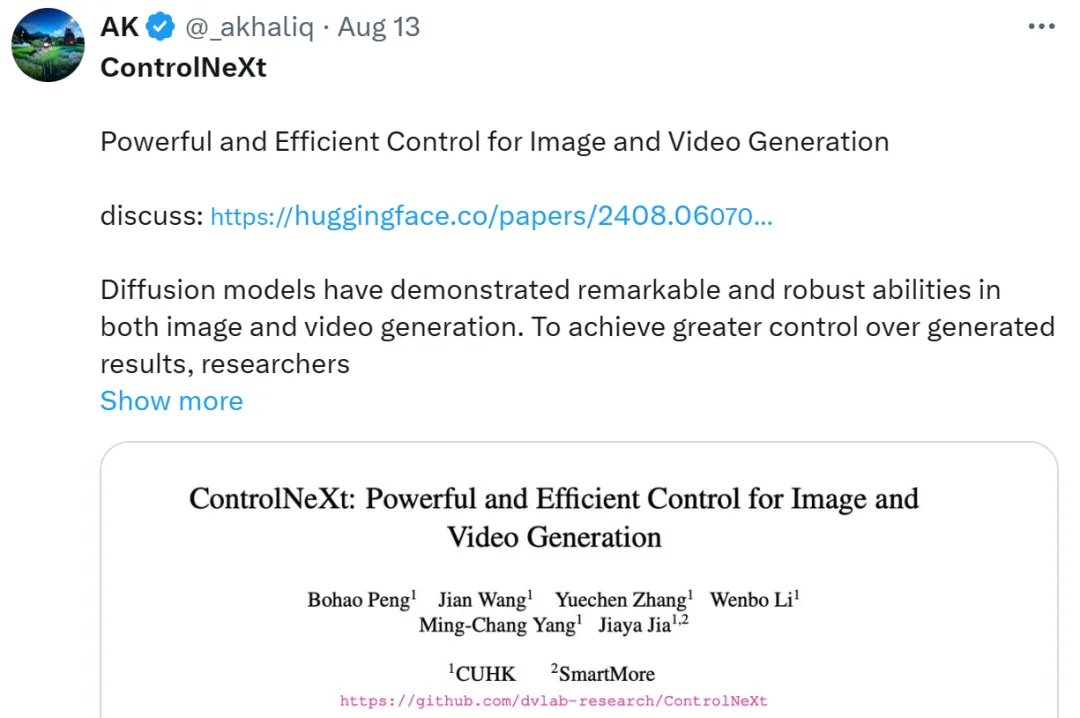

最近,又一款国产 AI 神器吸引了众网友和圈内研究人员的关注!它就是全新的图像和视频生成控制工具 —— ControlNeXt,由思谋科技创始人、港科大讲座教授贾佳亚团队开发。

为了实现算力层面的提升和追赶,国内有大量的厂商和从业者在各个产业链环节努力。但面对中短期内架构、制程、产能、出口禁令等多方面的制约,我们认为从芯片层面实现单点的突破依旧是非常困难且不足的。

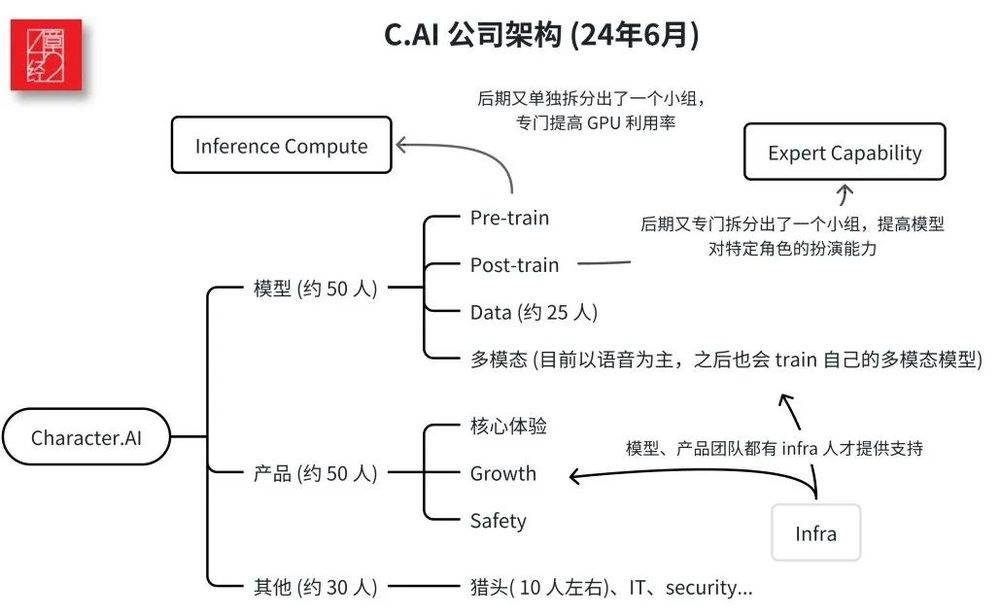

C.AI被收购是因市场和创始人选择,Scaling Law加剧了竞争。 • C.AI选择做模型公司以获得高估值。 • Google收购C.AI以应对AI市场竞争。 • Scaling Law使大模型公司竞争更激烈。

让模型具有更加广泛和通用的认知能力,是当前人工智能(AI)领域发展的重要目标。目前流行的大模型路径是基于 Scaling Law (尺度定律) 去构建更大、更深和更宽的神经网络提升模型的表现,可称之为 “基于外生复杂性” 的通用智能实现方法。然而,这一路径也面临着一些难以克服的困境,例如高昂的计算资源消耗和能源消耗,并且在可解释性方面存在不足。

非凡产研为大家整理编辑了近期微软CTO凯文·斯科特(Kevin Scott)接受红杉资本、Stratechery 采访回应关于大模型scaling laws、人工智能平台转变等焦点话题的精华内容。

最近的论文表明,LLM等生成模型可以通过搜索来扩展,并实现非常显著的性能提升。另一个复现实验也发现,让参数量仅8B的Llama 3.1模型搜索100次,即可在Python代码生成任务上达到GPT-4o同等水平。

为何会发生?可以避免吗?

Scaling Law还没走到尽头,「小模型」逐渐成为科技巨头们的追赶趋势。Meta最近发布的MobileLLM系列,规模甚至降低到了1B以下,两个版本分别只有125M和350M参数,但却实现了比更大规模模型更优的性能。

Scaling Laws当道,但随着大模型应用的发展,基础模型不断扩大的参数也成了令开发者们头疼的问题。